最近ますます身近になってきた生成AI。

毎日の仕事や調べものに欠かせない存在になってきましたが、クラウド上で使う以上、どうしても「この情報は入力していいのかな…?」と気になることってあると思います。特にセキュリティやプライバシーが大事な場面では、扱いにくいこともあります。

そんなときに安心なのが ローカルLLM。

そもそもローカルLLMとは?

LLM(大規模言語モデル)を、自分のPCやサーバーにダウンロードして動かす仕組みのこと。

普段のChatGPTのようにサーバーに送信するのではなく、自分のマシン上で動くので、入力した情報が外部に出る心配がありません。つまり「手元で動くAIアシスタント」みたいなイメージ。

実際に導入してみた

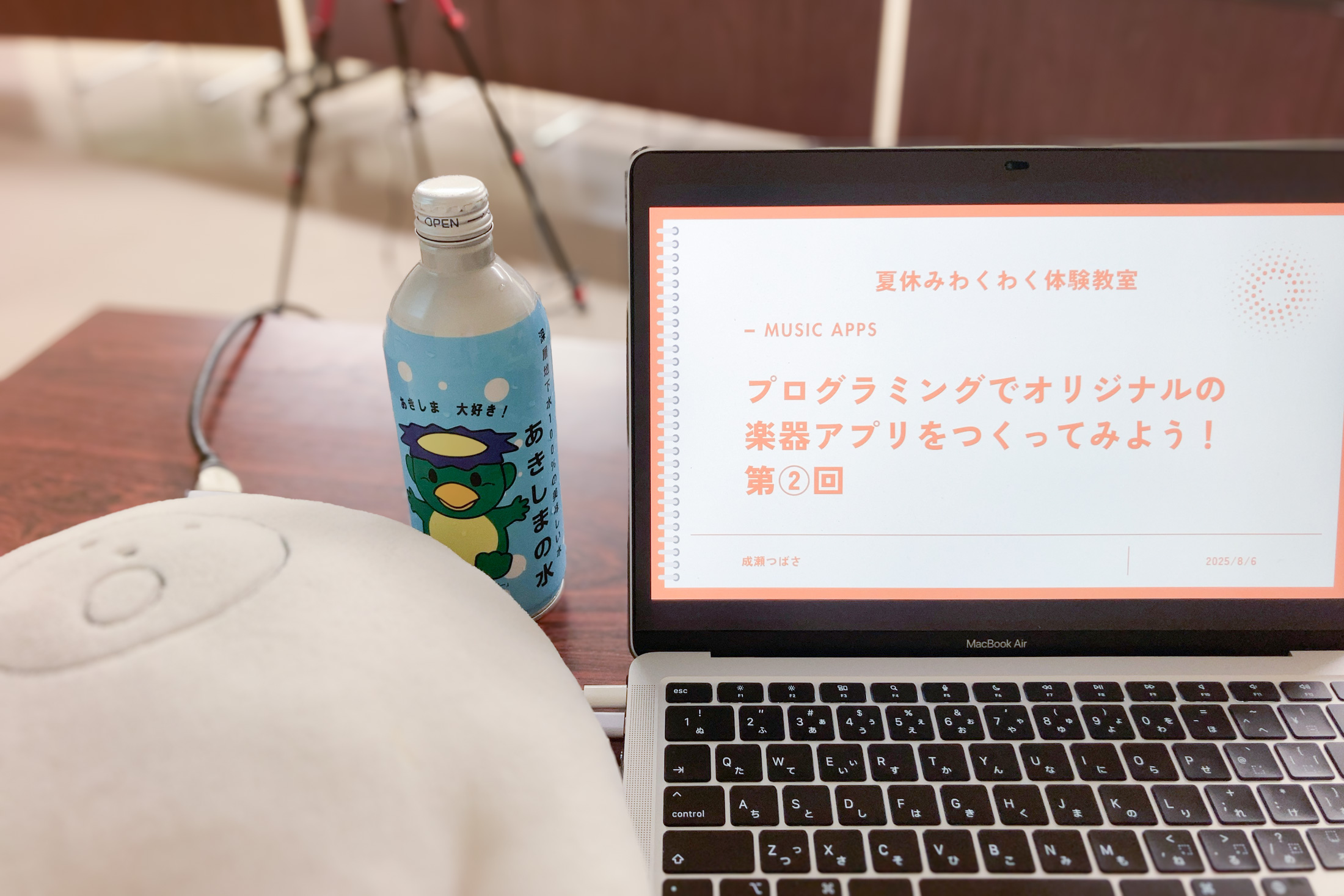

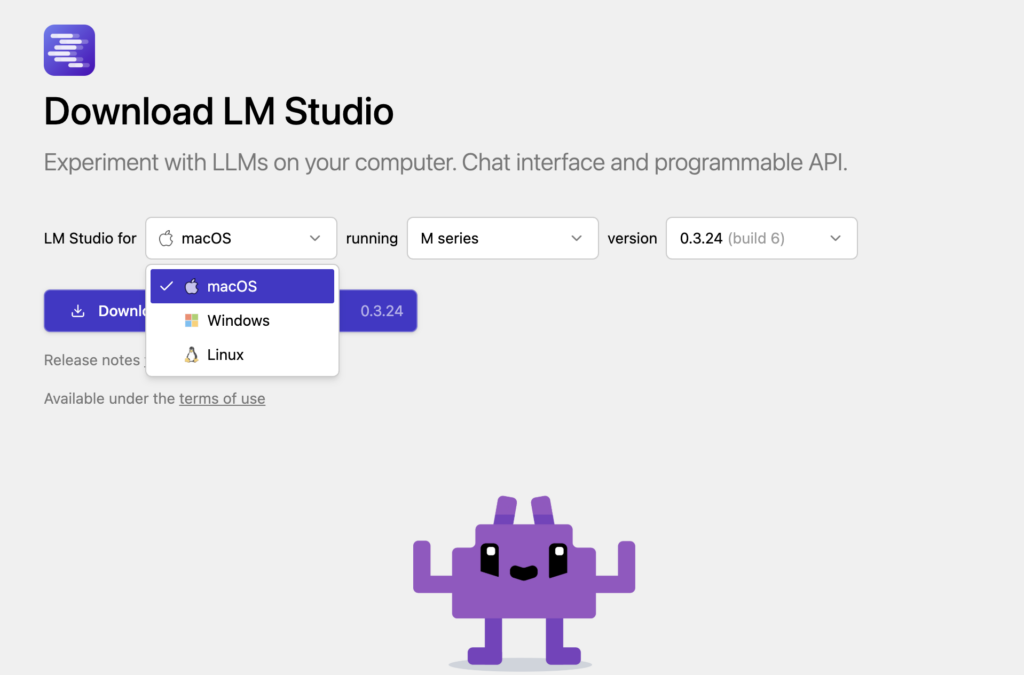

今回は LM Studio というアプリケーションを使って試してみました。Mac環境で動かしましたが、Windows版もあるので幅広く使えます。

無料で利用できます。(2025年8月時点。商用利用も無料とのこと!)

導入は本当にシンプルで、

- アプリケーションをインストール

- モデルを選んでダウンロード

大雑把にはこれだけ!

ちょうどタイミングよく、OpenAIが gpt-oss というローカルLLM対応モデルをリリースしたばかり。

試しに、普段使っているPC(MacBook Air、M1チップ、メモリ16GB)の環境で gpt-oss-20b を動かしてみたんですが、これはさすがにちょっと重めで低速(回答をもらえるまでに1分以上待たされることも)。さらに上の gpt-oss-120b だと80GBメモリが必要とのことで、これはさすがに手元のPCでは厳しいです。

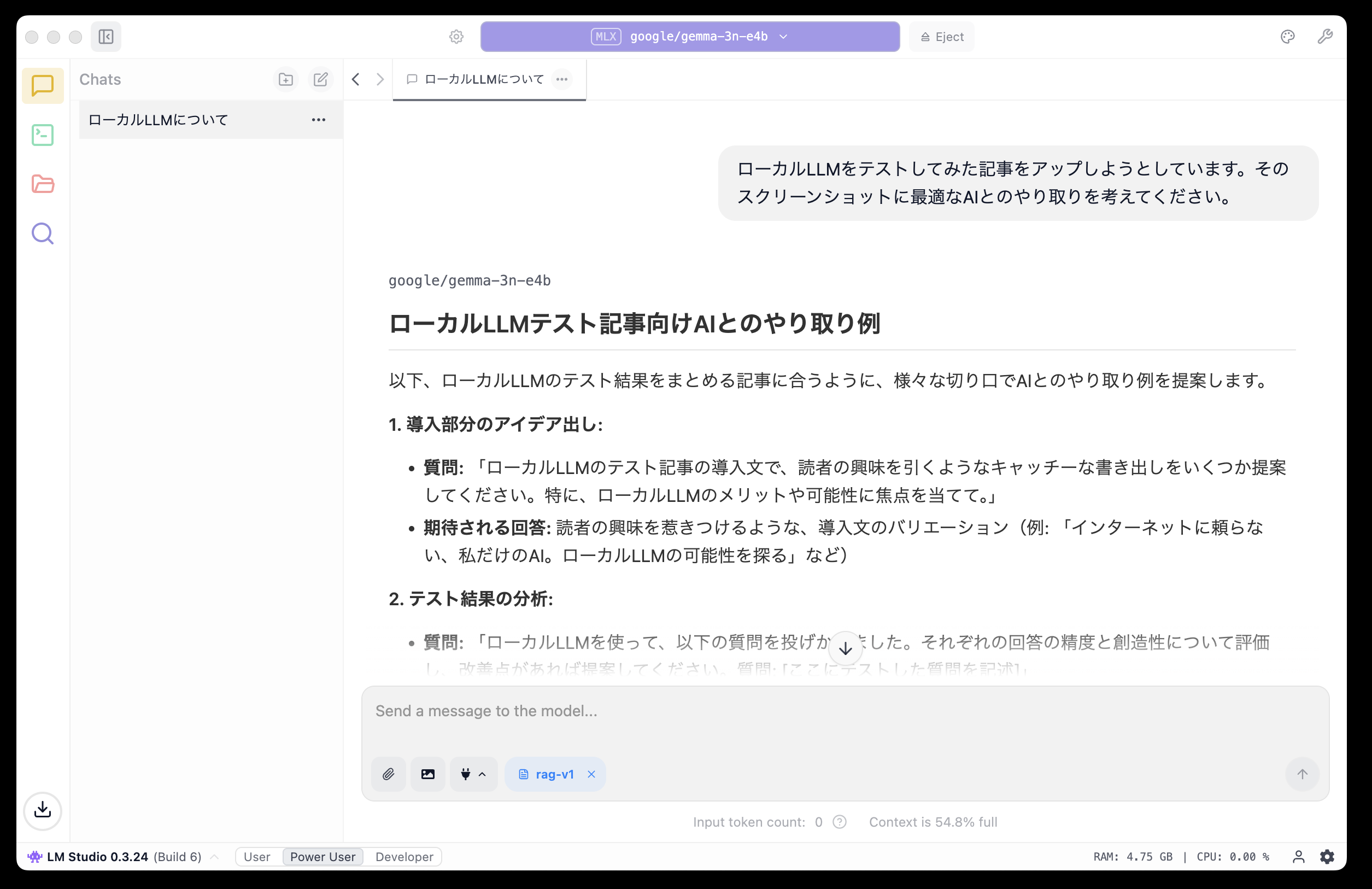

まだあまりたくさんのモデルを試せていないのですが、Googleの gemma-3n E4B というモデルがバランスよく動いてくれました。速度もそこそこで、出力のクオリティもそこそこという印象。

そのモデルでのチャットの使い心地はというと、オンラインのChatGPTよりちょっと遅いか、ほとんど変わらないくらい。これなら日常的に使えそうです。さらに便利なのは、PDFやCSVをアップして、それをもとに質問できる機能。手持ちの資料を読み込ませて、その場でQ&Aできるのは便利に思えます。

こんなときに便利!

オフラインで使える

出張先や電波がない場所でも問題なし。飛行機の中で資料を整理したいときなんかにも役立ちそう。

機密情報を扱える

外部に送信したくないデータも安心。社内の文書や研究データなどをベースにAIに相談できるのは、クラウド型ではなかなかできないメリットです。

まとめ

実際に触ってみて、「思った以上に手軽だし、これなら業務にも使えそう!」というのが正直な感想でした。

まだモデルの選択肢は限られていますが、日々進化している分野なので、今後はもっと軽量で高性能なモデルが増えていくはず。

「クラウドのAIはちょっと不安…」と思っている人や、「オフラインでもAIを活用したい!」という人は、一度ローカルLLMを試してみるのをおすすめします!